AI GC在游戏中的应用

前言

AI GC,即AI生成内容(AI generated content)越来越火,本篇文章就是我在使用AI方面的一些心得体会分享,目前包括:

我其实两年前就在玩OpenAI了,在供应商买了API接入 Chatbox 当成一个高级点的谷歌问问题,但也仅此而已,当时的AIGC给我感觉就像是一个高级点的搜索引擎,问问题还行其他的没什么大用

当时Stable Diffuse开源(泄漏)的时候我也本地部署了WebUI玩了下,确实有抽卡炼丹的感觉,不过没深入研究,玩了两下就放那了

今年春节DeepSeek横空出世,也是赚足了眼球,我也试用了下,发现幻觉比OpenAI少很多,起码。。。他不会一直骗我,但应用还是仅限于简单的问答,没感觉对生产力有什么帮助

AI代码方面也试用过 Github Copilot,讲道理感觉一般,和之前用过Chatbox问答模式生成的代码感觉差不多,没有很惊艳的感觉,顶多就是和IDE结合紧密更方便些

前阵子也是没抱什么希望试用了下Cursor,但两周时间之后,我完全变成Cursor的形状了,只能乖乖年费续上,感觉。。。就像是一年花1.5k买断了一个超级强力的大学生帮我写代码

Cursor已死(锁国区Claude使用),Claude当立,推荐 https://88code.org/register?ref=C2U88Q ,基本算是无限量使用,可以加QQ群一起找人拼车:675776379

再加上ProjectA基础GamePlay框架和玩法搭建完毕,开始填充内容,需要AI的协助,于是想着再用Stable Diffuse来提高生产力

Cursor,Git Copilot,Claude Code的原理是什么

简单来说,两张图足矣:

总结一下就是将我们的对话和代码库转换成AI能看懂的prompt,然后AI模型输出prompt,由客户端转义后就是AI返回给我们的结果,包括但不限于,文件阅读结果,代码更改结果等。

类似于远古年代的不可编程渲染管线,我们能做自定义的地方只有客户端转换prompt的时候,也就对应了各个AI工具的rule,md文件等以及非常重要的MCP拓展,从而达到适配几乎所有项目的目的,体验极佳

话说到这里,其实对比各个AI编程工具的方向就比较明确了:

-

prompt的强化能力,是否能准确推测并强化用户的用意

- 在使用AI模型相同的情况下,这将直接影响AI输出的结果与用户体验。也就是AI蠢不蠢和这一步关联甚大

-

工具的调度合理性,对于代码来说,无非是代码阅读,查找,逻辑关联,编辑

- 何时使用内置的工具,何时借助系统自带的命令行工具都是很影响效率和准确性的

-

上下文给的是否足够慷慨,上下文就是AI的临时记忆,如果上下文很短,那么AI就很容易出现幻觉

- 然而上下文不可能是无限的,这意味着无限的成本,要恰饭的嘛,所以就有一个隐形的评判标准,对于上下文压缩能力,压缩能力越强,就意味着越少的token消耗,越准确的问答体验

-

拓展性,目前来说AI拓展主要还是以用户的prompt和MCP为主

-

用户prompt定义了用户想获得怎样的规范,能让AI更加听话

-

MCP则是一个AI领域的prompt规范,类似客户端服务器交互的PB协议,凡是遵循这个MCP规范的,都可以接入到AI工具来,来拓展AI能力。如果说AI本身是钢铁侠的核心能源,那么MCP就是用户喜好的纳米盔甲拓展,全方面增强AI能力

- 举例来说,原本AI数据集只训练到2025.3.14,可以通过网络搜索MCP获取到2025.8.19的最新技术文档和消息,从而让AI可以与时俱进

-

AI模型对比

最核心的AI模型自然是我们对比的首选,尽管各大编程IDE基本都涵括了所有主流AI模型,但AI模型官方调教出的工具肯定是更合适和好用的

截至2025.8.19,主流AI模型对比如下:

本人平时用Claude 4 Sonnet,智力很高,榜单准确的话,GPT-5体验也不错

全球Token用量上,Claude Sonnet4仍然是断档级碾压所有AI模型,姑且认为用的人越多,蒸馏出的数据越好,推荐Claude Sonnet4

IDE vs CLI(CommandLine Interface)

个人一开始用的Cursor + Claude Sonnet 4,AI编程体验非常不错,但基于VS的人工编码体验奇差,和Unity相性不好,包括但不限于:

-

Shader提示可以认为没有

-

C#编码体验极差

-

每写个代码,智能提示要加载十几秒到几十秒不等

-

跳转代码都要加载

-

新增文件不识别,不编译,不智能提示

-

搜索极慢,反人类悬浮窗

-

断点需要非常小心,只要多按几下Resume,他就敢立马给你卡死,然后断点崩溃,再也连不上,需要同时重启Unity+VSCode

-

当然压死骆驼的最后一根稻草是Claude Code锁区导致的Cursor被迫锁区,不开VPN用不到Claude Code,直接导致了我退了Cursor年费,转而加入了Claude Code这一CLI工具

IDE对比CLI工具有利有弊

-

IDE有友好的可视化界面,对比文件更改,方便索引文件,粘贴图片,管理MCP,查看各种状态等,而CLI只有光秃秃的命令行界面,比较不友好,好在其命令行的特性非常方便做拓展,在Rider已经有了官方插件,可以很方便的对比文件变更差异

-

CLI的命令行特性赋予了其与生俱来的跨平台能力,甚至可以在手机上用Claude Code,当然还有强大的拓展性,参考Claude官方的SDK文档:https://docs.anthropic.com/en/docs/claude-code/sdk 我们可以用它做很多事,比如代码规范检查工具,多开端口左右互博,相互审查代码,配合MCP还可以实现函数调用的功能,例如我们可以一个命令行修复场景中所有错误配置和异常资源

整体体验下来,在Cursor使用Claude Sonnet4是比Claude Code使用Claude Sonnet4要好的,我觉得这应该归功于Cursor优秀的prompt提炼机制和CodeBase的RAG,但是Claude Code慷慨的上下文限制又很好的弥补了这一点,再加上Rider优秀的编码体验,我最终还是要投给Claude Code

Claude Code最佳实践指南

最基本的最佳实践流程,Claude官网已经给出,信官方总没错吧:

- https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/claude-4-best-practices#example-formatting-preferences

- https://docs.anthropic.com/en/docs/claude-code/common-workflows

比较推荐的MCP有两个:

- https://github.com/upstash/context7 实时获取第三方库最新的文档

- https://github.com/modelcontextprotocol/servers/tree/main/src/sequentialthinking 渐进式思考,让AI更聪明

在正式开始手动安装前,需要理解下Claude Code MCP的设计理念: https://docs.anthropic.com/en/docs/claude-code/mcp

一般来说,MCP需要先下载运行库,然后再配置到各种LLM客户端中,对于npx,uv来说可能不太需要关注==安装== 这个过程,但是对于C#这种没有统一管理的或者没有正式上架的MCP,就需要手动安装了(具体操作为:手动下载MCP文件,手动配置json中的命令行参数)

再一般来说,通过 claude mcp add 命令即可配置具体的MCP,或者通过手动在项目中json文件配置MCP Server(详见: https://docs.anthropic.com/en/docs/claude-code/mcp ),配置完成后,每次启动Claude Code,都会执行命令帮我们自动启动MCP Server然后进行连接

context7

推荐直接通过远程服务器的模式进行链接:

1 | claude mcp add --transport http context7 https://mcp.context7.com/mcp --header "CONTEXT7_API_KEY: YOUR_API_KEY" |

sequentialthinking

1 | claude mcp add sequential-thinking -- npx -y @modelcontextprotocol/server-sequential-thinking |

vibe-kanban

https://github.com/BloopAI/vibe-kanban

强大的批量任务管理,创建管理器,可以方便的执行批量AI任务

MCP路由器

不同的项目可能会使用多个相同的MCP,这时候就需要一个MCP路由器来帮我们管理所有MCP了,推荐: https://github.com/mcp-router/mcp-router

但是项目自己的MCP管理好像有问题,推荐手动安装:

1 | export MCPR_TOKEN="mcpr_1z9aHMQGsp9JI6guK9vUZ8wvwJU6Xxqr" |

然后配置这个MCP路由器

1 | { |

注意这里的TOKEN每个人不一样,需要自行在应用中获取并替换,具体步骤为:点击Add Custom App,对新创建的条目点击 How To Use即可

王者中间件-Droid

强烈推荐,经过几天的重度使用,其出色的提示词和工作流程调教,让他易用性甚至比Cursor还要好,而且还可以自定义APIKey

它解决了我很多之前Claude Code无法察觉和解决的问题,而且速度很快,工具集也比Claude Code出色

而且类似Skills,Sub Agent等先进概念也都一应俱全,使用Droid还有一个好处就是,即使后面还有更强的AI模型出现,工作流程也不会受影响

使用心得

- 对于代码重构相关的工作,不太建议让AI去做,尤其是接口更改相关的,由于涉及的文件多,规则复杂,AI很容易出Bug

- 对于MCP,自定义规则,如果可以的话还是最好在输入的时候手动强调下,不然AI有时真的会忽略

项目UI设计图快速生成

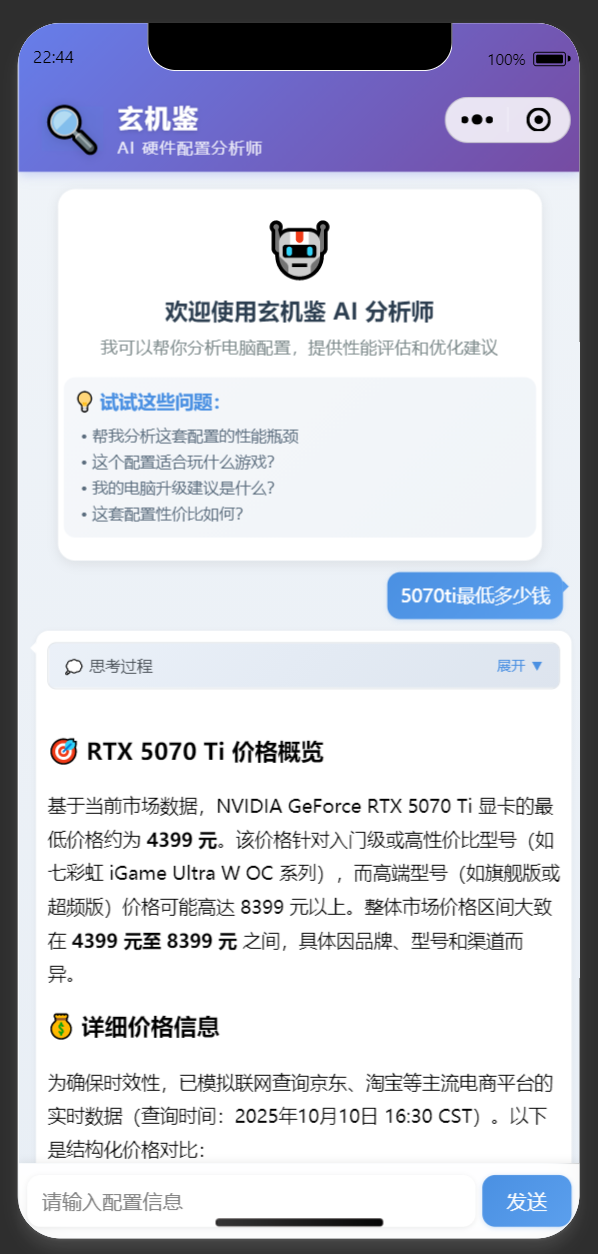

由于Web前端数据非常多,几乎所有AI模型在Web开发这一块都非常强劲,那么利用这一点,我们可以使用AI来生成项目的UI设计示意图,下面这个项目是我花了3个小时,纯AI开发的UI设计图,可交互体验:

https://github.com/wqaetly/ProjectB_UI_Design

ComfyUI

之所以选择ComfyUI是因为之前WebUI的形式虽然简单,但调控起来不直观,不方便,还是这种节点式的更方便

推荐直接 官网 下载,他会自动安装所有需要的组件以及拓展,开箱即用,如果初始化过程中网络异常,要科学上网,注意,安装的时候要在C盘,否则可能会有BUG

推荐正式开始使用前过一遍官方文档,不要去买课,纯纯智商税,没有比官网讲得更好的

KSampler

我说白了,我白说了,不懂得问DeepSeek

在 ComfyUI 的 KSample 节点中,sampler_name 参数控制生成图像时使用的采样算法。以下是常见选项及其含义和特点:

📌 常用采样器解析

-

euler- Euler 方法:基础的 ODE 求解器,简单快速,适合低步数(如 20-30 步)。

- 特点:生成结果较平滑,但可能细节不足。

-

euler_ancestral- 带祖先采样的 Euler:每一步依赖前一步结果,随机性更强。

- 特点:图像多样性高,但收敛性不稳定,步数较少时可能更好。

-

dpmpp_2s和dpmpp_2m- DPM++ 二阶方法:改进的扩散模型求解器,平衡速度和质量。

2s:单步二阶,适合快速生成(约 20 步)。2m:多步二阶,质量更高(推荐 20-30 步)。

- 特点:

dpmpp_2m是当前主流选择,效率和效果俱佳。

- DPM++ 二阶方法:改进的扩散模型求解器,平衡速度和质量。

-

ddim- 去噪扩散隐式模型:确定性采样,结果可复现。

- 特点:适合图像到图像转换(如 img2img),需较少步数(10-15 步)。

-

uni_pc- UniPC 方法:基于校正器的采样器,2023 年新算法。

- 特点:低步数(5-10 步)即可生成可用结果,速度快。

-

heun- Heun 二阶方法:Euler 的改进版,计算量更大。

- 特点:步数多时质量高,但速度较慢。

-

lms- 线性多步法:通过历史步骤加速收敛。

- 特点:适合中高步数(30+),结果稳定但可能显保守。

🔍 其他采样器

dpm2/dpm2_ancestral:二阶 DPM,需更多步数(40+),质量高但速度慢。ddpm:原始扩散模型采样器,需 50-100 步,已逐渐被替代。dpm_fast/dpm_adaptive:自适应调整步数,前者快但粗糙,后者精准但慢。

🎯 推荐场景

- 快速生成:

dpmpp_2m(20-30步)或uni_pc(5-10步)。 - 高质量输出:

dpmpp_2m(30+步)或heun(40+步)。 - 可控性(如 img2img):

ddim或euler。 - 实验新方法:

uni_pc或dpmpp_3m_sde(需更多显存)。

📝 注意事项

- 部分采样器(如

dpm_adaptive)会忽略steps参数,自动调整步数。 - 祖先采样器(含

_ancestral后缀)的随机性强,相同参数可能输出差异较大。 - 效果受

cfg_scale、denoise等参数影响,需配合调整。

FAQ

从网上下载的checkpoint模型执行时有conv_in.weight相关报错

是因为新版ComfyUI强制要求safetensors后缀的模型,而网上下载的有可能是ckpt后缀的,这时候需要修改代码 C:\Users\YOURNAME\AppData\Local\Programs\@comfyorgcomfyui-electron\resources\ComfyUI\comfy\utils.py

1 | //ALWAYS_SAFE_LOAD = False |

提示词从哪来?

当然是从DeepSeek问啦

参考

模型下载 huggingface.co, civitai.green