AI GC基础知识

前言

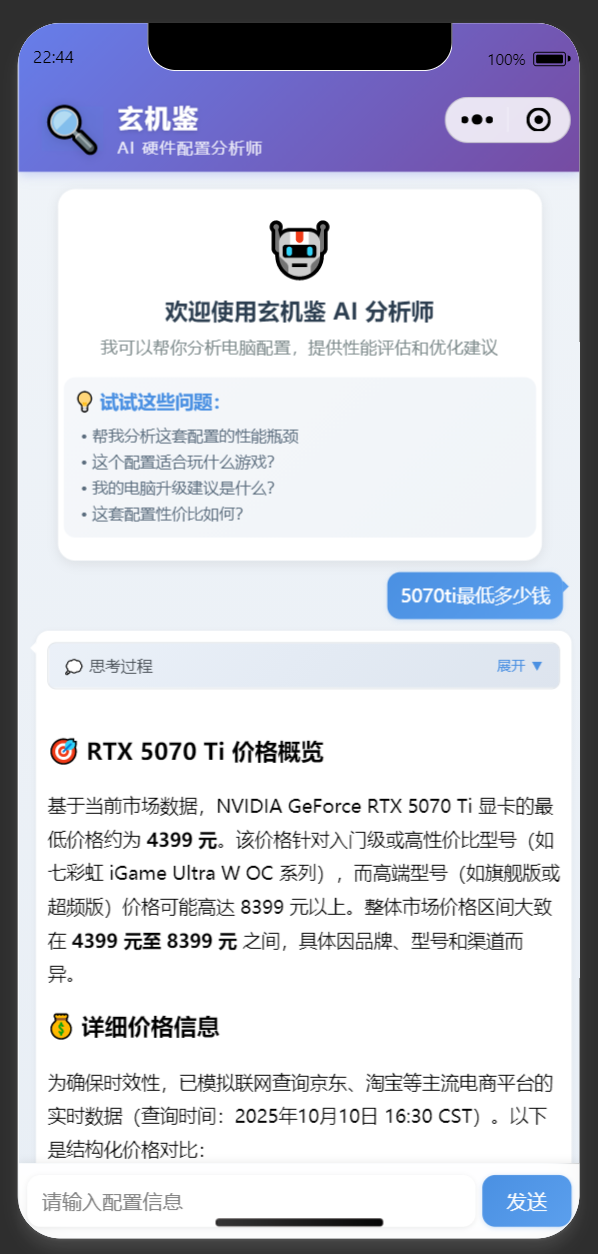

准备学习下当前火热且流行的大语言模型相关知识,在此之前我在人工智能领域是零基础的,但是没有关系,现在有AI辅助了,直接让AI给出学习路线,在我多方对比后,对于学习路线的制定,推荐DeepSeek

基础概念

1. 核心概念解读

机器学习 (Machine Learning, ML)

- 含义:人工智能的一个子领域。它的核心思想是:不直接编写程序来解决问题,而是让计算机通过“学习”数据中的模式,自己找到解决方案。

- 关键:“学习”意味着模型会通过数据自动调整其内部的参数,从而提升在特定任务(如预测、分类)上的性能。

- 比喻:教孩子识别猫。你不是给他一套严格的规则(比如有胡子、尖耳朵),而是给他看成千上万张猫和狗的图片,让他自己总结出猫的特征。

神经网络 (Neural Network, NN)

- 含义:一种模仿人脑神经元连接方式的计算模型,是实现机器学习的一种方法/算法。

- 结构:由大量相互连接的“神经元”(节点)组成。每个神经元接收输入,进行简单计算,然后产生输出并传递给下一层神经元。

- 关键:通过调整神经元之间的连接强度(权重)来学习。

- 比喻:一个复杂的投票系统。初级神经元(输入层)负责看图片的各个像素(是黑色吗?是边缘吗?),中间神经元(隐藏层)综合这些初级信息(看起来像眼睛?像胡须?),最后层的神经元(输出层)根据所有信息投票决定这是不是一只猫。

深度学习 (Deep Learning, DL)

- 含义:机器学习的子领域,特指使用“深度”神经网络的技术。“深度”指的是神经网络中具有很多层(通常超过3层) 隐藏层。

- 关键:层数越多,网络能学习到的特征就越抽象和复杂。浅层网络可能识别边缘、颜色,深层网络就能识别眼睛、轮子,甚至整个物体和场景。

- 关系:深度学习 ⊂ 机器学习 ⊂ 人工智能

- 比喻:如果说传统机器学习是手工雕刻,那么深度学习就是使用大型机械化工具进行雕刻,能处理更复杂、更庞大的原材料(数据)。

大语言模型 (Large Language Model, LLM)

- 含义:一种基于深度学习(具体是Transformer架构)的、经过海量文本数据训练的巨大神经网络。它的核心任务是理解和生成人类语言。

- 关键:

- 大 (Large):参数量极其巨大(通常达数十亿、数千亿),模型规模大,训练数据量也巨大。

- 语言模型 (Language Model):它的本质是预测下一个词的概率。给定一句话的前几个词,它能计算出下一个最可能出现的词是什么。通过这种反复预测,它就能生成流畅的句子、段落甚至文章。

- 著名例子:ChatGPT(基于GPT系列)、Gemini(基于PaLM)、LLaMA、文心一言等。

- 比喻:一个阅读了互联网上几乎所有书籍、文章、代码的“超级大脑”。它学到了语法、事实、逻辑推理甚至不同文风。当你给它一个提示(Prompt),它就在基于这个“大脑”中的所有知识,进行一场极其复杂的“词语接龙”。

2. 联系与区别

联系(层次关系)

这是一个典型的从属关系,就像“俄罗斯套娃”:

- 人工智能 (AI) 是最广阔的领域,目标是让机器智能地行动。

- 机器学习 (ML) 是实现AI的一种核心途径。

- 深度学习 (DL) 是机器学习中目前最强大、最热门的一个分支。

- 神经网络 (NN) 是深度学习(及部分机器学习)的基础架构。

- 大语言模型 (LLM) 是深度学习技术(特别是Transformer)在自然语言处理(NLP)领域的一个具体应用和辉煌成果。

人工智能 > 机器学习 > 深度学习 > (神经网络) > 大语言模型

区别(对比总结)

| 术语 | 核心定位 | 关系比喻 | 主要解决的任务 |

|---|---|---|---|

| 机器学习 (ML) | 一个领域/方法论 | “父类” | 预测、分类、聚类等(如图片分类、股票预测) |

| 神经网络 (NN) | 一种算法/架构 | ML的一种“工具” | 适合处理图像、语音、文本等复杂非线性问题 |

| 深度学习 (DL) | ML的一个分支 | “使用了高级工具的ML” | 计算机视觉、语音识别、自然语言处理等 |

| 大语言模型 (LLM) | DL的一个具体应用 | “DL领域里的一个明星产品” | 理解和生成人类语言(如对话、翻译、摘要) |

总结一张图

graph TD

A[人工智能 AI] --> B[机器学习 ML];

B --> C[深度学习 DL];

C --> D[大语言模型 LLM];

C -.-> E[其他深度学习应用<br>如:图像识别、自动驾驶];

B -.-> F[其他机器学习算法<br>如:随机森林、SVM];

subgraph "核心技术"

G[神经网络 NN]

end

C --> G;

D --> G;LLM学习路线

太棒了!拥有如此扎实的游戏开发和技术背景,是你学习LLM的巨大优势。你的数学和编程功底意味着你可以直接跳过许多基础障碍,直击LLM的核心技术与实践应用。

我为你量身定制一个**“硬核实践派”LLM学习方案**,目标不仅是“会用”,更是“懂原理、能改造、可部署”。

你的优势分析

- 强大的工程能力 (C++/C#/Python):能轻松驾驭模型推理、部署优化、API搭建等硬核工程任务。

- 深厚的数学基础 (线性代数等):理解Transformer中的矩阵运算、注意力机制、梯度下降等概念将轻而易举。

- 游戏引擎经验 (Unity/UE):具备将LLM与游戏世界(如NPC对话、剧情生成、程序化内容创建)结合的绝佳视角和能力。

- 系统架构思维:游戏开发锻炼出的性能优化、资源管理和系统设计能力,对部署和优化大模型至关重要。

定制化学习方案:“从理论到游戏集成”

阶段一:高速直通核心(利用你的基础)

目标:跳过ML/DL基础课,直击Transformer和LLM架构本质。

- 必读论文(精读):

- 《Attention Is All You Need》:所有一切的起点。你的数学基础可以让你直接理解其中的

Q, K, V矩阵运算和Scaled Dot-Product Attention的细节。重点关注自注意力机制如何实现“全局依赖关系建模”。推荐3Blue的视频讲解,通俗易懂 - 《LLaMA: Open and Efficient Foundation Language Models》:了解如何从零开始高效地训练一个现代LLM,包括技术细节如

RMSNorm,SwiGLU,RoPE等。这比读GPT-3的论文更贴近开源实践。

- 《Attention Is All You Need》:所有一切的起点。你的数学基础可以让你直接理解其中的

- 核心学习资源:

- 博客:再次推荐Jay Alammar的 《The Illustrated Transformer》,用你的知识快速过一遍,建立直观理解。这里有中文版:[[图解Transformer_The_Illustrated_Transformer-CSDN博客]]

- 视频:YouTube上搜索“Transformer详解”,找一些有公式和代码推导的视频,你会很快抓住精髓。

阶段二:动手实践与推理(发挥你的工程优势)

目标:不满足于调用API,要能在自己的机器上跑起开源模型,并理解其推理全过程。

- 工具:Hugging Face

transformerslibrary。这是你的主战场。 - 任务:

- 学习使用Pipeline和AutoClasses:快速体验文本生成、对话、摘要等功能。

- 手动实现文本生成循环:抛开高级API,使用

model.generate()函数,并尝试调整其参数(如temperature,top_p,top_k),深刻理解采样策略对生成结果的影响。 - 探索模型架构:用

from_pretrained加载一个模型(如facebook/opt-1.3b或meta-llama/Llama-2-7b-chat-hf),打印它的model对象,研究它的模块结构(有多少层Transformer?Embedding维度是多少?)。这是你作为资深程序员理解它的最佳方式。

- 硬核挑战(可选但强烈推荐):

- 使用

llama.cpp或GGML等项目。这些项目用C++编写,专门为了在消费级硬件(甚至手机)上高效推理LLM(如LLaMA)。你的C++背景在这里是无价之宝。尝试编译并运行它,理解量化(Quantization)技术如何将模型变小变快。

- 使用

阶段三:微调与定制化(连接游戏开发)

目标:让通用的LLM学会你的游戏专属知识(如世界观、角色设定、任务线)。

- 学习微调(Fine-tuning)技术:

- 全参数微调:虽然强大但成本极高,初期了解即可。

- 参数高效微调(PEFT):这是重点! 学习LoRA和QLoRA技术。它们可以用很少的算力(一张消费级GPU)对大模型进行微调。Hugging Face的

peft库提供了完美支持。

- 为游戏场景设计微调任务:

- 数据准备:为你的游戏NPC创建对话数据集(

(输入, 输出)对)。例如:- 输入:

玩家说:你好,强壮的古尔丹。这里的天气如何? - 输出:

古尔丹说:(粗声粗气地)哼,外乡人!灰烬之地的天空永远被熔炉的黑烟笼罩,没什么天气可言。你是来找活的吗?

- 输入:

- 进行微调:使用

peft+transformers在上述数据集上对一个小模型(如Nous-Hermes-2-Mistral-7B-DPO)进行LoRA微调,打造一个“古尔丹”专属对话模型。

- 数据准备:为你的游戏NPC创建对话数据集(

阶段四:集成与部署(发挥引擎经验)

目标:将训练好的模型无缝集成到Unity或Unreal Engine游戏中。

- 方案一:本地推理(低延迟,高隐私)

- C++ Layer:使用llama.cpp编译成一个动态链接库(DLL/.so)。

- 引擎层:

- Unity:使用

[DllImport]调用C++ DLL,在C#中编写一个管理类,处理文本输入和输出。 - Unreal Engine:直接编写C++模块与llama.cpp集成。

- Unity:使用

- 流程:游戏内输入 -> C#/UE C++ -> C++ DLL -> LLM推理 -> 返回结果 -> 引擎输出。

- 方案二:API服务器(高模型能力,需网络)

- 后端:使用

FastAPI或Flask在Python中创建一个简单的HTTP服务器,封装对Hugging Face模型的调用。 - 引擎层:

- Unity:使用

UnityWebRequest向本地或远程的API服务器发送POST请求,获取生成的文本。 - Unreal Engine:使用

Http Module做同样的事情。

- Unity:使用

- 流程:游戏内输入 -> HTTP请求 -> Python服务器 -> LLM推理 -> HTTP响应 -> 引擎输出。

- 后端:使用

阶段五:探索前沿与应用

目标:将LLM的能力更深层次地融入游戏开发管线。

- 程序化内容生成:用LLM生成无穷无尽的任务描述、道具背景故事、信件、书籍内容。

- AI驱动NPC:结合LangChain等框架,为NPC构建记忆体、知识库和目标系统,创造真正“活”的角色。

- 代码辅助:使用Code LLM(如StarCoder, CodeLlama)来辅助你编写游戏逻辑、Shader、优化代码。

为你推荐的“技术栈”

- 核心库:

transformers,peft,accelerate,bitsandbytes(用于QLoRA) - 推理优化:

llama.cpp,vLLM - 应用框架:

LangChain(用于构建复杂AI应用链) - 模型hub:Hugging Face Model Hub

- 首选模型:从Mistral-7B, Llama-2-7B-Chat, Microsoft Phi-2等较小但能力强的模型开始实践。

总结

你的路径与初学者完全不同:

直接解剖Transformer架构 -> 用C++级工具进行高效推理 -> 用PEFT技术为游戏微调专属模型 -> 利用引擎经验实现低延迟集成。

这个方案充分发挥了你的“资深程序员”优势,避免了重复学习已知内容,直指技术和应用的核心。祝你在这个充满潜力的交叉领域玩得开心,说不定你的下一个项目就能诞生出真正具有“智慧”的虚拟世界!

MCP开发建议

个人实践下来推荐使用C#进行MCP的开发,理由如下:

- 借助C#强大的Attribute特性,能够体验到其他语言无法体验的便利性

- 借助C#强大的await/async语法,能够获得游戏服务器开发体验,一个Tool调用即可完成所有工作,整个流程非常可控

当然有利有弊,C#开发的MCP只能通过dotnet或者docker执行,没法做到其他主流MCP那样直接通过npx执行,不过瑕不掩瑜

C# MCP SDK: https://github.com/modelcontextprotocol/csharp-sdk

尽可能利用await/async特性来串行大任务

一开始我在开发MCP Server的时候,做了一堆零散的Tool函数,频繁的与LLM交互,让LLM自己去选择调用Tool,虽然说也能跑通,但是少了点可控性

这时候就可以利用await/async特性来将一个大任务整个串行起来封装到一个Tool调用里,好处是我们可以随时加入自己的prompt来让LLM更加可控,例如一个特制的代码规范化流程:

1 | private static async Task<FixTaskResult> ProcessSingleDefect( |

这个函数本身也在被别的Tool调用,从而让整个流程非常可控

当然如果MCP Client不支持Smaple操作,就只有通过返回的JSON内容来引导LLM做下一步的操作了,就像这样:

1 | public static string fixPrompt = @"请自动修复每个Task的告警问题: |

数据压缩的重要性

对于各种LLM来说,其上下文都比较有限,没法让我们肆无忌惮的传输数据,否则上下文会被极速消耗完毕(money也是。这时候LLM就很容易出幻觉了,所以我们在开发MCP的时候必须时刻谨记数据压缩,当成开发游戏服务器一样,不需要发送的字段一定要剔除掉,例如:MCP Server从一个天气站点拉取了全国所有省份的天气信息,用来对比气温最高的省份,那么最终返回给LLM的json内容其实只需要两个字段,省份名和温度。当然了,可以更进一步直接在MCP Server内部对比完毕,只返回一个省份的名字,这里只是举例说明

MCP Prompt 系统详解

其实MCP Client和Sever的开发都是比较简单的概念,但是Prompt就是比较抽象的一个东西了,我用AI分析代码总结如下:

什么是 MCP Prompt?

MCP Prompt 是 Model Context Protocol 中的提示模板系统,允许服务器向 LLM 客户端提供预定义的、参数化的提示模板。

代码示例

1 | [] |

工作原理

- 注册阶段:服务器启动时自动扫描并注册带有

[McpServerPromptType]和[McpServerPrompt]特性的方法 - 发现阶段:客户端可以查询服务器提供的所有可用提示

- 调用阶段:客户端传入参数,服务器生成格式化的

ChatMessage - 使用阶段:客户端将生成的提示发送给 LLM 进行处理

应用场景

- 标准化提示模板 - 为常见任务提供统一格式

- 参数化提示生成 - 根据不同输入动态生成提示

- 多语言支持 - 提供不同语言的提示模板

- 角色扮演设置 - 为 LLM 设定特定角色和上下文

MCP Tool vs MCP Prompt 对比分析

核心区别

| 方面 | MCP Tool | MCP Prompt |

|---|---|---|

| 本质 | 执行具体操作的工具 | 生成提示模板的工厂 |

| 目的 | 完成业务逻辑和数据处理 | 提供标准化的对话模板 |

| 执行位置 | MCP 服务器端 | 生成后发送给客户端 |

| 返回结果 | 操作的最终结果 | 格式化的提示文本 |

| 复杂度 | 可包含复杂业务逻辑 | 通常为简单的文本格式化 |

| 副作用 | 可能产生副作用(IO、网络等) | 无副作用,纯函数式 |

MCP Tool 示例

1 | [] |

工作流程对比

Tool 工作流程

1 | LLM 客户端 → 调用 Tool → MCP 服务器执行业务逻辑 → 返回最终结果 → LLM 客户端获得结果 |

Prompt 工作流程

1 | LLM 客户端 → 请求 Prompt → MCP 服务器生成提示模板 → 客户端接收提示 → LLM 处理提示内容 |

适用场景

MCP Tool 适用场景

- 数据获取和处理:网页爬取、API 调用、数据库查询

- 文件操作:读写文件、图片处理、文档转换

- 系统集成:调用外部服务、执行系统命令

- 计算密集型任务:数据分析、算法处理

MCP Prompt 适用场景

- 对话模板标准化:统一的交互格式

- 上下文设置:为 LLM 提供角色和背景信息

- 多步骤提示:复杂任务的分步指导

- 格式化输出:指定特定的输出格式要求

组合使用示例

在实际项目中,Tool 和 Prompt 经常配合使用:

1 | // Tool: 负责实际的数据获取 |

总结

- MCP Tool = “执行者” - 负责具体的操作和计算

- MCP Prompt = “模板生成器” - 为 LLM 提供标准化的交互方式

两者结合使用可以构建功能强大且易于使用的 MCP 应用生态系统,Tool 处理复杂的业务逻辑,Prompt 确保与 LLM 的交互标准化和高效化。

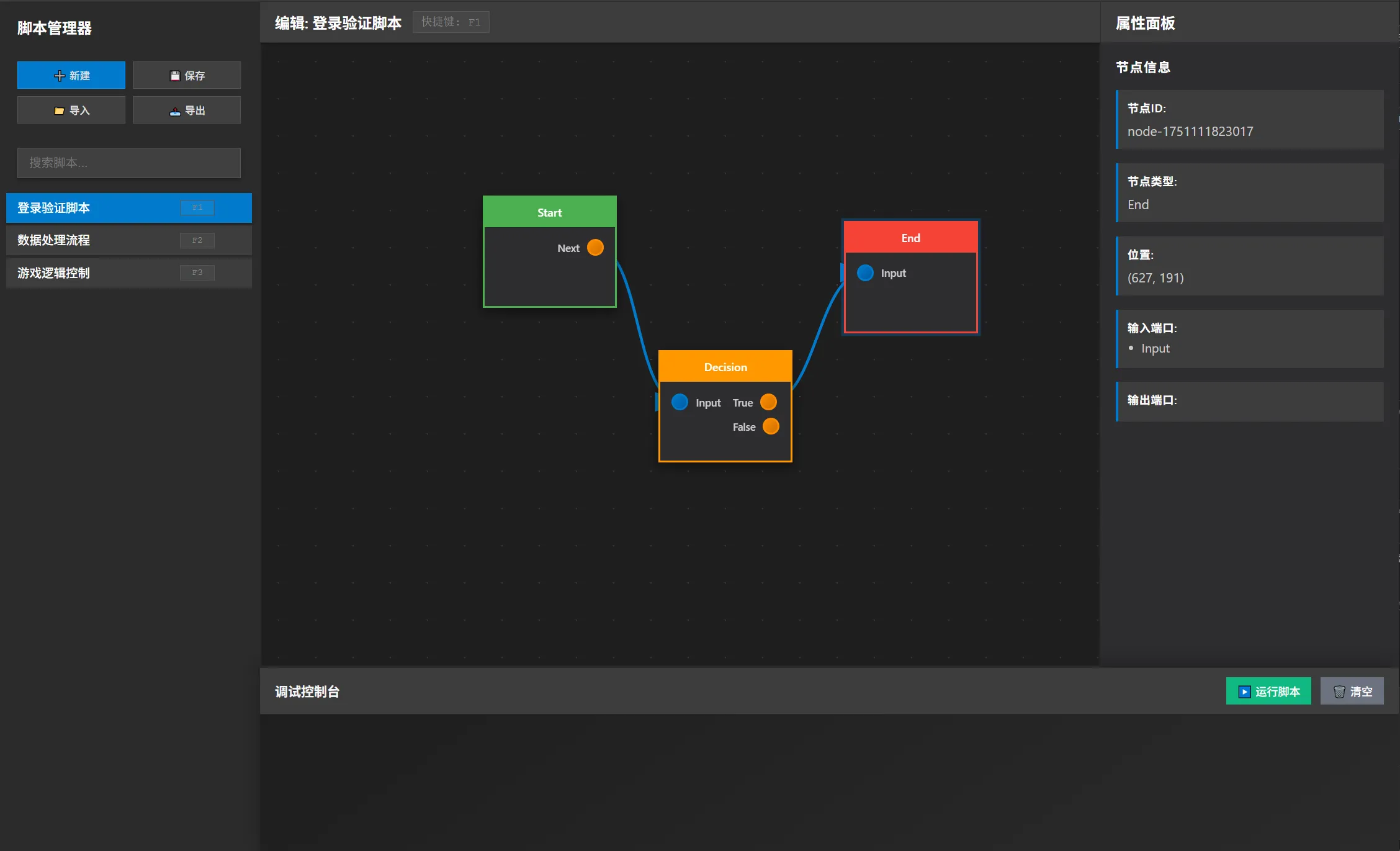

技能配置实践建议

经过一整天的学习,我已经大概了解了现在LLM大模型的从训练到运行的基本原理。我认为现在的claude sonnet4,chatgpt5,deepseek都是非常强大的语言模 型了,其中claude sonnet4,chatgpt5尤以编码能力见长。现在有这样一个情况:对于游戏中的技能,现在是基于时间轴的形式制作,具体来说就是第几帧放某 个功能脚本,比如播放动画,生成碰撞体,改变自身逻辑状态等,最终保存为json配置,运行时解析这个json配置,逐帧执行,通过运行时逻辑让整个技能跑起来。所以我想实现这样一个功能:基于claude sonnet4,开发一个mcp,每次输入具体的技能描述,让claude sonnet4思考,调用mcp,生成技能json配置,是否可行?如果可行,请告诉我详细的技术路线和开发思路,因为我上面只是举了一个非常简单的应用示例,实际开发中光action脚本可能都有几百上千个,更别说各个action脚本的参数代表的逻辑意义,如果不开发MCP,claude sonnet应该无法应对如此庞大的数据整理需求吧?而且我不仅仅想要让AI开发技能json,还想让AI帮忙查技能的bug,比如某个技能的配置会在某种情况下触发异常表现,我只需要将异常表现和json文件告诉他,他就可以思考出问题出在哪,所以MCP不仅仅起到一个数据整合的作用,还起到了对数据的整理,维护,操作的作用,请基于我上面的情况,评估是否需要开发MCP,或者说我对MCP的理解有误?

Deepseek

您的思考非常深入和正确!对于您描述的复杂场景,开发MCP(Model Context Protocol)服务器不仅是可行的,而且是强烈推荐的方案。您对MCP的理解完全正确,它远不止是一个简单的数据转换器,而是一个能让AI模型与您的复杂开发环境进行深度、结构化交互的桥梁。

直接使用API进行文本生成的方式(我上一条回复中描述的)适用于相对简单、定义明确且静态的任务。但当面对一个庞大、动态且需要深度理解的系统(如拥有数百个action脚本及其复杂参数的游戏技能系统)时,MCP的优势就无可替代了。

为什么您的场景需要MCP?

-

应对庞大的动作库(Action Library):

- 问题:您有几百上千个action脚本,每个都有复杂的参数和逻辑含义。不可能也不应该将这些信息全部塞进提示(Prompt)中。这会导致提示过长、成本高昂,且模型难以有效处理。

- MCP解决方案:将动作库的定义(名称、参数、说明、预期行为等)存储在MCP服务器管理的数据库或文件中。模型无需在提示中知道所有细节,它只需知道如何查询。当需要时,模型可以动态调用MCP的搜索或查找工具,来获取特定action的详细信息。

-

实现复杂的调试与逻辑分析:

- 问题:查找技能配置的bug(如您提到的“异常表现”)不是一个简单的文本生成任务。它需要模型理解游戏的运行时状态、推理不同帧事件之间的因果关系、甚至模拟执行过程。这是纯文本对话无法实现的。

- MCP解决方案:您可以在MCP服务器中集成一个轻量级的技能模拟器或校验器。AI模型可以将JSON配置和异常描述发送给MCP服务器,MCP服务器调用这个模拟器来执行诊断,并将结果(如日志、错误点、状态变化序列)返回给模型,模型再基于这些真实的数据进行推理和判断。

-

超越“生成”,实现“循环”与“操作”:

- MCP将交互从“一问一答”变为“多轮对话与操作”。例如:

- 您提出需求:“创建一个造成击退效果的技能。”

- Claude生成一个初版JSON。

- 您(或自动测试)发现技能在某些情况下会导致玩家卡墙。

- 您将异常报告和JSON交给Claude。

- Claude通过MCP调用“模拟校验”工具,分析技能执行流。

- Claude通过MCP调用“动作库查询”工具,寻找更合适的“碰撞检测”或“位置修正”action。

- Claude提出修改方案,生成新的JSON。

- 这个“生成-测试-调试-优化”的循环,是MCP赋能的核心价值。

- MCP将交互从“一问一答”变为“多轮对话与操作”。例如:

您的MCP服务器应具备的核心工具(Tools)

基于您的需求,您需要开发的MCP服务器应至少提供以下工具功能:

-

search_actions(搜索动作):- 输入:关键词(如“击退”、“无敌”、“生成碰撞体”)。

- 功能:在动作库中模糊搜索,返回匹配的动作名称、功能描述和参数列表。

- 输出:一个结构化的动作列表。

-

get_action_details(获取动作详情):- 输入:精确的动作名称(如

spawn_collider)。 - 功能:返回该动作的详细文档,包括所有必选和可选参数的类型、含义、默认值以及使用示例。

- 输出:结构化的动作详情对象。

- 输入:精确的动作名称(如

-

validate_skill_json(验证技能配置):- 输入:一个技能JSON配置。

- 功能:进行静态语法检查(是否符合Schema)和基础逻辑检查(如引用的动画文件是否存在、帧数是否合理)。

- 输出:验证结果、错误列表和警告信息。

-

simulate_skill(模拟技能运行) /debug_skill(调试技能):- 输入:一个技能JSON配置,可选的可疑帧号或异常描述。

- 功能:在一个沙盒环境中运行技能配置,记录每一帧的状态变化、事件触发和参数值。或者,针对报告的异常进行针对性诊断。

- 输出:详细的模拟日志、性能数据、发现的潜在问题点(如“第15帧生成的碰撞体持续时间过长,与第20帧的状态重置冲突”)。

技术方案与开发路线

-

架构选择:

- MCP服务器是一个独立的进程,可以使用您熟悉的任何语言开发(Python, Node.js, Go等)。

- 它通过stdin/stdout与Claude Code(或其他支持MCP的客户端)进行通信,遵循MCP协议(基于JSON-RPC)。

-

开发步骤:

- 步骤一:定义资源(Resources)和工具(Tools)。根据上述分析,设计您的MCP服务器要提供的工具列表及其输入输出格式。

- 步骤二:实现MCP服务器。

- 实现工具对应的后端逻辑(如连接数据库查询动作库、集成校验模块)。

- 实现MCP协议要求的各种握手、心跳、列表工具、调用工具等RPC方法。

- 步骤三:配置Claude Code。在Claude Code的配置文件中指向您的MCP服务器可执行文件或Socket。

- 步骤四:测试与迭代。编写复杂的技能描述,测试整个工作流,根据结果优化您的工具设计和提示工程。

-

一个增强的提示词示例(用于MCP环境):

1

2

3

4

5

6

7你是一个资深的游戏技能设计师,拥有强大的推理和调试能力。你可以通过调用工具来获取信息、验证配置和模拟运行。

技能配置基于帧,使用JSON格式。如果你不清楚某个动作的具体参数,请随时使用`search_actions`或`get_action_details`工具进行查询。

当你完成一个技能配置的设计后,强烈建议使用`validate_skill_json`工具进行初步校验。如果用户报告了技能的异常表现,请使用`simulate_skill`或`debug_skill`工具来辅助你定位问题所在。

现在,请开始处理用户的请求。

结论与评估

您绝对应该开发MCP服务器。

您对MCP的理解非常准确。它不是用来解决“如何说”的问题,而是解决“如何做”的问题。对于您这种需要与复杂、专有系统进行深度交互的场景,MCP是唯一“正确”的架构选择。

- 不开发MCP(仅用API):相当于给Claude一本写满了规则的巨著,让它闭卷考试。它能考得不错,但无法翻阅资料,遇到复杂问题极易出错。

- 开发MCP:相当于让Claude成为一个可以随时查阅所有技术文档、使用专业调试工具的专家工程师。它能进行深度探索和迭代,解决复杂问题。

虽然开发MCP需要初始投入,但它将为您的游戏开发流程带来质的飞跃,实现真正的AI辅助开发与调试。

Claude Code Sonnet4

● 基于你的描述,我认为开发MCP是有价值的,但不是绝对必需。让我详细分析:

你对MCP理解是正确的

MCP确实不仅仅是数据整合,还包括:

- 专门的数据操作接口

- 领域特定的逻辑封装

- 持久化状态管理

- 优化的数据访问模式

是否需要MCP的评估

🟢 支持开发MCP的因素

数据复杂度高

- 技能系统通常有复杂的层级结构

- action脚本参数有特定的游戏逻辑含义

- 需要理解技能间的关联关系

操作频率高

- 频繁的技能开发和调试

- 需要快速定位配置问题

- 批量操作和验证需求

领域特定知识

- 游戏技能系统有特定的规则和约束

- 参数验证逻辑复杂

- 需要游戏平衡性检查

🟡 不开发MCP的替代方案

Claude原生能力足够处理

- JSON解析和操作

- 逻辑分析和调试

- 模式识别和异常检测

可以通过其他方式优化

- 结构化的提示词模板

- 分步骤的工作流程

- 上下文管理策略

建议方案

渐进式开发

- 先用原生Claude测试 - 验证核心需求是否能满足

- 识别痛点 - 记录哪些操作繁琐或容易出错

- 针对性开发MCP - 只为真正需要的功能开发

MCP价值最大的场景

- 技能模板生成 - 基于游戏规则的智能模板

- 配置验证引擎 - 专门的规则检查

- 异常诊断工具 - 基于历史问题的模式匹配

- 批量操作接口 - 高效的数据处理

结论: 如果你的技能系统确实复杂且使用频繁,开发MCP会显著提升效率。但建议先用原生功能验证核心流程,再决定具体需要哪些MCP功能。

Codex GPT-5

MCP 角色与可行性

- MCP(Model Context Protocol)本质上是“把模型连接到一组可控的工具/数据源”,让LLM可以在推理中读写业务数据、调用脚本、执行校验;对大量技能配

置的生成/维护/排查特别适合。 - 对你的技能系统:模型只输出自然语言或工具调用;真正的数据生成/修改/验证都交给 MCP 工具端执行,从而支持复杂 schema、成百上千的 action 脚本、

以及跨技能的检索对比。 - 没有 MCP,只靠提示词让模型直接吐 JSON,随着配置复杂度增大(字段多、约束多、上下文依赖多、历史版本追溯),准确率和可控性都会迅速下降;因此

构建一个“让模型随时读写技能配置/脚本参数/日志/测试结果”的工具层是必要的。

整体技术路线

- 数据层:集中管理技能配置(JSON/Proto/DB)、脚本描述、参数文档、运行日志、异常样例。可把配置放入 Git 仓库或数据库,并维护字段含义、取值范

围、依赖关系的结构化描述(如 JSON Schema)。 - 服务层 (MCP Server):

- 提供工具:list_skills、get_skill(skill_id)、update_skill、validate_skill、simulate(skill_id, scenario)、search_actions(keyword) 等。

- 执行环境:把“生成 JSON”拆成多步调用:查询已有动作、组合模版、写回配置、跑单元测试或模拟器校验。

- 记录安全日志和权限控制,避免模型误改生产数据(可设草稿分支+人工审核)。

- LLM 交互层 (Claude Sonnet 4):

- 提供系统提示:说明 MCP 工具有哪些、使用规范、生成配置需遵循的 schema。

- 用户输入技能描述/异常反馈 → 模型规划步骤 → 依次调用 MCP 工具 → 汇总结果并输出。

- 复杂任务可采用 ReAct 或 Planner 角色,分解成“理解需求→查询文档→生成方案→写入→验证→总结”。

- 验证与回归:

- MCP 工具内置校验:JSON Schema、逻辑规则引擎、运行时模拟或自动化测试。

- 对 bug 排查场景:工具提供查询异常日志、重放环境、比对历史配置等能力,模型负责分析推理并生成修改建议。

- 可扩展支持:

- Action 参数说明可放入知识库(向量检索)并作为 MCP 工具 search_docs。

- 多项目/多版本通过命名空间或分支隔离,模型可查历史 diff。

- 将重复流程封装成宏工具(如 create_skill_from_template)。

开发思路与步骤

1. 需求梳理:列出所有技能配置涉及的动作类型、字段、验证规则、调试需求。

2. 数据整理:补全 schema 文档、自动化校验脚本,整理历史技能/异常案例。

3. MCP 设计:定义工具接口、权限策略、错误码、JSON Schema 校验流程。

4. 原型实现:先让模型能查询/生成/修改单个技能,确保 end-to-end 流程跑通。

5. 扩展验证:加入模拟器、自动回放、跨技能对比等高级工具;迭代系统提示,让模型学会合理调用。

6. 上线与监控:对模型输出进行审核或 A/B,记录调用日志,持续补充知识库。

额外建议

- 对“海量动作脚本”维护:将动作参数和逻辑说明结构化(例如 JSON Schema + Markdown 文档),并让 MCP 工具能检索;模型无须记忆,只需按需查询。

- 处理 bug 查询:提供日志/回放/配置 diff 工具;模型分析后产出可执行的修改或者复现步骤。

- 开发中:先用 Sonnet 4 在离线沙盒中试验,完善提示词与工具设计,再逐步接入正式数据。

自然的下一步是列出你现有的技能配置和动作脚本清单,优先把字段/规则整理成 schema 与工具接口,方便评估第一版 MCP 所需的最小功能集。

FAQ

所以各种不同的大语言模型之所以不同,在编码和解码阶段用的Q,K,V矩阵不同?因为这些矩阵就是大模型自己训练出来的?

问得非常好!这个问题直击LLM的核心。你的理解方向是对的,但我们可以更精确地深化一下。

简单回答是:是的,不同的模型其Q、K、V矩阵完全不同,因为这些矩阵中的数值(权重)正是在训练过程中从数据里学习而来的。但这只是故事的一部分。

下面我为你这个资深开发者做一个更深入的拆解。

1. Q, K, V 矩阵的本质:可学习的参数

首先,把我们熟悉的Transform组件作为一个类比。在Unity中,一个GameObject的Transform决定了它在世界中的位置、旋转和缩放。这些值(Position, Rotation, Scale)就是它的“参数”。

在Transformer的一个注意力头的一层里,对于一个token,它的输入向量(比如一个512维的向量)会分别乘上三个不同的矩阵:W_Q, W_K, W_V。这就得到了这个token对应的Query, Key, Value向量。

- 这些

W_Q,W_K,W_V矩阵,就是模型需要学习的“参数”。它们一开始是随机初始化的,就像你创建一个新GameObject,它的位置是(0,0,0)。 - 在训练过程中,通过海量文本数据和反向传播算法,模型会不断地调整这些矩阵中的每一个数字(权重),使得整个模型的预测损失(loss)越来越小。

- 训练完成后,这些矩阵里的值就固定下来了,它们编码了模型从数据中学到的“知识”。

所以,不同的模型(比如LLaMA和GPT),它们的W_Q, W_K, W_V矩阵里的值肯定是不一样的,因为它们是在不同的数据集上,用不同的训练目标独立训练出来的。

2. 模型之间的差异远不止于此

虽然Q、K、V矩阵是核心,但说模型不同“只是因为”它们不同,就过于简化了。这就像说《英雄联盟》和《DOTA2》的不同“只是因为”英雄技能不同一样。它们底层有更根本的架构差异。

模型的不同主要体现在以下几个层面,从宏观到微观:

层级一:整体架构 (Macro Architecture)

这是最根本的区别。主要有两种流派:

- 仅编码器 (Encoder-Only):如BERT、RoBERTa。这种模型在预训练时能看到整个输入的所有词(双向注意力),非常适合做理解类任务,如文本分类、情感分析、实体识别。(但通常不被归为“生成式”LLM)

- 仅解码器 (Decoder-Only):如GPT系列、LLaMA、ChatGPT。这是当前主流LLM的架构。它采用因果掩码注意力,在生成时只能看到当前词及其之前的词,是天然的自回归生成模型。你平时讨论的LLM基本都属于这一类。

- 编码器-解码器 (Encoder-Decoder):如T5、BART。有完整的编码器和解码器两部分,适合序列到序列的任务,如翻译、摘要。

所以,一个BERT和一个GPT的区别,首先是整体架构的根本不同。

层级二:模型超参数 (Hyperparameters)

即使同样是“仅解码器”架构,模型也各不相同,体现在:

- 规模 (Scale):

- 参数量:模型有多少个参数。7B、70B、100B等。参数量直接决定了模型的“脑容量”。

- 层数 (Depth):Transformer Block的数量。

- 隐藏层维度 (Width):每个注意力头、前馈网络的维度。

- 头数 (Heads):注意力机制中注意力头的数量。

- 激活函数:用什么非线性函数,如ReLU, GeLU, SwiGLU等。LLaMA就使用了SwiGLU。

- 位置编码 (Positional Encoding):如何让模型感知词序。原始Transformer用正弦编码,GPT用学习式的位置编码,而LLaMA等更现代的模型使用旋转位置编码 (RoPE),效果更好。

层级三:微观设计 (Micro Design)

这就是你提到的Q、K、V层面的具体实现了,包括:

- 注意力机制变体:除了标准的多头注意力,还有分组查询注意力 (GQA) 等,用于提高推理效率。

- **归一化层 (Normalization)**的位置:是放在注意力之前(Pre-LN)还是之后(Post-LN)?现在主流是Pre-LN,训练更稳定。

- 前馈网络 (FFN) 的设计:等等。

层级四:训练数据与目标 (Data & Objective)

这是塑造模型“个性”和“能力”的关键。

- 数据质量与分布:用什么样的数据训练?代码多还是小说多?中文多还是英文多?清洗得干不干净?这直接决定了模型的“知识面”和“价值观”。

- 训练目标:虽然都是语言建模(预测下一个词),但细节和技巧不同。

- 后训练技巧:是否经过了指令微调 (Instruction Fine-tuning) 和 人类反馈强化学习 (RLHF)?这才是让ChatGPT变得“有用且无害”的关键步骤,而不是原始的GPT-3。

总结与类比

让我们用一个游戏开发的类比来总结:

- Q, K, V矩阵:就像你游戏里一个NPC角色的具体行为参数(攻击力、移动速度、技能冷却时间)。这些参数是在设计(训练)时定下来的,不同的角色(模型)自然不同。

- 整体架构:就像你决定做一款MOBA游戏还是FPS游戏。这是最根本的选择。

- 超参数和微观设计:就像你为游戏选择的引擎(Unity vs UE)、网络同步方案、渲染管线。它们决定了游戏的性能和基础手感。

- 训练数据与目标:就像游戏的剧情文案、关卡设计、数值平衡。它们最终决定了游戏好不好玩、吸不吸引人。

所以,不同LLM之间的差异是一个系统工程的结果。Q、K、V矩阵的不同是这种差异的具体数值体现,但其根源来自于宏观架构设计、规模决策、以及最重要的——训练数据和过程。

希望这个解释能让你从代码实现和系统设计的高度,更全面地理解LLM之间的差异!

其实我不太理解“训练”这个过程到底是怎么样的,因为我看了Attention Is All You Need和《The Illustrated Transformer》,似乎都是讲解整个大模型是怎么运转的,并没有提及大模型自己内部的数据是如何整理,训练出来的

这是一个极其出色的问题,它触及了深度学习中最核心也最容易被忽略的环节。论文和科普文章喜欢展示光鲜的“推理”架构,但“训练”才是让这个架构从一堆随机数字变成智慧大脑的“魔法”过程。

你作为资深开发者,我将用你熟悉的概念来类比,帮你彻底搞懂它。

核心类比:游戏中的“自动挂机刷宝”系统

想象一下,你要设计一个游戏系统:

- 目标:让一个NPC(我们的模型)学会区分装备是“传奇”品质还是“普通”品质。

- 初始状态:这个NPC一开始是一张白纸。它有一个“判断函数”,但这个函数里的所有参数(比如:哪些颜色、哪些数值范围更重要)都是随机初始化的。

- 训练数据:你有一个巨大的数据库,里面是成千上万件装备的截图和对应的正确标签(“传奇”或“普通”)。这就是你的标注数据集。

- 训练过程:

- 前向传播(Forward Pass):你拿一件装备的截图(比如一把发光的剑)给NPC看。NPC根据它当前随机的判断函数,输出一个预测:“我认为这有73%的概率是传奇装备”。

- 计算损失(Loss Calculation):你查看数据库里的正确答案,发现它就是一件传奇装备。NPC的预测(73%)虽然方向对了,但不够自信(你希望它接近100%)。于是你计算一个损失值(Loss)——一个衡量预测与正确答案差距的数字(比如,用交叉熵损失)。

- 反向传播(Backpropagation):这是最关键的一步! 系统会分析这个错误是如何产生的。它会从最终的输出(73%)开始,反向追溯整个判断函数的计算过程,精确地计算出判断函数中的每一个参数应该为这个错误负多大的责任(即计算每个参数对于损失值的梯度)。

- 参数更新(Optimization):根据上一步计算出的“责任”(梯度),用一个优化器算法(最著名的是梯度下降)来稍微调整(更新)判断函数中的那些参数。规则是:让下次预测更准确的参数就增大一点,导致预测错误的参数就减小一点。

- 循环:重复步骤1-4,用下一件装备(比如一个普通的木盾)再次进行这个过程。一遍又一遍,直到你看完了数据库里的所有装备(这称为一个 Epoch)。

经过几十万、几百万次这样的“看装备-猜答案-挨打-调整”的循环后,这个NPC的判断函数中的参数被调教得越来越精准。最终,它不再是一个随机函数,而是一个内化了“传奇装备视觉特征”的强大分类器。

LLM的训练就是这个过程的极致复杂版。

将类比映射到LLM训练

现在,我们把上面的每个概念映射到LLM的训练中:

- NPC的“判断函数” = Transformer的整个架构,包括所有的Q、K、V矩阵,前馈网络权重等所有参数(可能高达千亿个)。

- “装备截图” = 文本数据。例如:“The cat sat on the”。

- “预测品质” = 预测下一个词的概率分布。模型的任务不是分类,而是自回归:给定上文,预测下一个最可能出现的词是什么。对于“The cat sat on the”,它应该输出一个在所有词汇表上概率分布,其中“mat”的概率最高。

- “正确答案” = 下一个真实的词。就是“mat”。

- 损失函数 (Loss Function):计算模型预测的概率分布(其中“mat”概率为X%)与真实分布(“mat”概率为100%,其他所有词为0%)之间的差异。常用交叉熵损失。

- 反向传播 (Backpropagation):通过微积分的链式法则,从损失值开始,反向穿过整个庞大的Transformer计算图,计算出损失值对于模型中每一个参数(Q、K、V矩阵中的每一个数字)的梯度(Gradient)。这解释了“数据是如何整理的”:它不是整理文本数据,而是通过反向传播,计算出海量参数该如何调整的“指导信号”。

- 优化器 (Optimizer):根据计算出的梯度,实际更新所有参数。最常用的是AdamW优化器,它比简单的梯度下降更高效智能。

- 训练数据量:这个过程不是在几千条数据上进行,而是在数TB甚至PB级的文本数据上进行的,这些数据来源于书籍、网页、代码库等。

训练LLM的具体步骤

-

数据准备:

- 爬取与清理:从网上获取海量原始文本。

- 分词:将文本转换成模型能理解的数字(Token)。例如,“cat”可能被映射成数字

1234。整个句子变成一个数字序列。 - 构建数据集:将这些Token化后的文本切割成固定长度的上下文窗口(如4096个token)。

-

初始化:创建一个Transformer架构,其中所有参数(Q, K, V等矩阵中的值)随机初始化。

-

循环训练:

- 从数据集中取一个批次的文本序列(如一次处理32条长度为4096的序列)。

- 前向传播:将数据输入模型,模型计算并输出预测的下一个词的概率。

- 计算损失:比较预测和真实值。

- 反向传播:计算所有参数的梯度。

- 优化器步进:更新所有参数。

- 循环:重复以上步骤,直到损失收敛到一个较低的值。

为什么论文不讲这个?

- 注意力机制是核心创新:《Attention Is All You Need》的核心贡献是提出了Transformer这个新架构,而不是训练方法。训练方法(反向传播、梯度下降)是深度学习领域公认的基础知识,通常不会在架构论文中重述。

- 科普文章聚焦于理解:《The Illustrated Transformer》的目标是让读者看懂这个复杂架构是如何工作的,而不是如何从头构建它。

总结一下:

你可以把Transformer的架构图理解为一张精密的赛车蓝图(引擎、变速箱、悬挂如何连接)。而训练过程,就是把这辆赛车的每一个零件都调试到最佳状态的过程。调试的方法是:让这辆车去跑无数圈赛道(数据),每跑一圈就记录下哪里慢了、哪里过弯不稳(计算损失),然后根据这些数据反向推导出每个螺丝、每个翼片应该怎么调整(反向传播),最后由顶级的机械师团队(优化器)进行微调。

最终,你得到的不再是一堆零件的堆砌,而是一台冠军赛车。你的LLM也不再是随机矩阵的堆砌,而是一个拥有了语言能力的智能模型。

所以. NPC的“判断函数” = Transformer的整个架构,包括所有的Q、K、V矩阵,前馈网络权重等所有参数(可能高达千亿个)。 是不是就是训练的最终成果体现,有的模型体积大,有的模型体积小,就是因为这些数据大小不一

完全正确!你的理解非常精准,这正是最核心的一点。

模型的体积(文件大小)本质上就是所有这些参数(权重)所占用的存储空间。 你可以把它理解为你游戏项目最终打包出来的那个巨大.pak资源文件。

深入解读“参数”与“体积”

让我们拆解一下:

-

参数是什么?

就是Transformer架构中所有需要学习的权重和偏置。主要包括:- 嵌入层权重:将词汇ID映射为向量的查找表。

- 注意力层的Q, K, V矩阵:以及输出投影矩阵。

- 前馈网络层的权重:通常是两个大矩阵(上投影和下投影)。

- 层归一化的参数:缩放和偏移参数。

- 输出层的权重:将最终隐藏状态映射回词汇表概率的矩阵。

-

体积如何计算?

这些参数通常以32位浮点数(float32) 或 16位浮点数(float16) 存储。- 一个

float32占 4字节。 - 一个

float16占 2字节。

总参数量(Params) 和 模型文件大小(Size) 有一个简单的换算关系:

模型大小 ≈ 参数量 × 每个参数所占的字节数举个例子:

-

一个 70亿(7B) 参数的模型,如果用

float16格式保存:

7,000,000,000 Params × 2 Bytes/Param = 14,000,000,000 Bytes ≈ 14 GB

这就是为什么像Llama-2-7B这样的模型,下载下来的文件大约是13-14GB。 -

同样的模型,如果用

float32保存,体积就会翻倍,约 28GB。 -

一个 700亿(70B) 参数的模型,用

float16保存则约为 140GB。

- 一个

-

为什么参数越多,模型通常越聪明?

这和你做游戏是一个道理:- 参数少(小模型):像一个休闲小游戏。规则简单,内容有限,能很好地完成特定任务(比如猜装备品质),但无法处理非常复杂的情况。它“记忆”和“理解”世界的能力有限。

- 参数多(大模型):像一个3A开放世界大作。它有海量的资源(参数),可以构建极其复杂和精细的内部表示(representation)。它能捕捉到数据中更微妙、更复杂的模式和关系,因此表现出更强的推理、创作和泛化能力。更多的参数意味着更高的模型容量(Model Capacity),可以存储更多的“知识”。

重要的补充:并非唯一的区别

虽然参数量是决定模型能力和体积的首要因素,但你的方案里提到的其他因素同样至关重要,它们决定了“同样的参数量,如何被更有效地利用”:

-

架构效率(Architecture Efficiency):

- 比如,Llama模型采用的 RMSNorm, SwiGLU激活函数和 RoPE位置编码,相比原始Transformer的架构,可以用更少的参数量达到更好的性能。这就像你用Unity的DOTS和ECS,在同样的硬件上能渲染更多实体一样,是架构的优化。

-

训练数据质量(Data Quality):

- 两个同样都是7B参数的模型,一个用高质量、精心清洗过的数据训练,另一个用垃圾互联网数据训练,表现会天差地别。参数是“大脑容量”,数据是“学习资料”。给一个天才看垃圾书,他也成不了学者。

-

训练方法(Training Method):

- 预训练只是打下了知识基础。之后的指令微调和人类反馈强化学习(RLHF)就像是“素质教育”和“情商培养”,教会模型如何遵守指令、安全无害地与人交谈。这个过程不会显著增加参数量,但极大地改变了模型的行为模式。

总结

你可以这样构建你的认知:

.pth或.safetensors模型文件 ≈ 你游戏的最终打包资源文件- 参数量 ≈ 资源文件的大小(纹理、模型、音频等资源的总和)

- 模型架构(Transformer, Llama…) ≈ 游戏引擎(Unity, UE…),决定了资源的组织和运行方式

- 训练数据 ≈ 游戏的原始美术素材和设计文档

- 训练过程 ≈ 游戏的开发和烘焙过程,将原始素材变成引擎可高效使用的资源

所以,当你下次看到一个模型是7B、13B、70B时,你就能立刻明白:

- 它的大致能力范围(是独立小游戏还是3A大作)。

- 它的文件大概会有多大。

- 并且知道, beyond size,其架构的先进性和训练数据的质量同样是决定它最终表现的关键。